大模型落地,如何告别“部署焦虑”?

DeepSeek-R1 的惊艳表现无需赘述,但企业落地时的高门槛却让许多开发者望而却步——复杂的部署流程、资源调度难题、高昂的运维成本……

现在,KubeSphere 社区交出了一份新答卷:仅用3天,基于Luban 架构开发出 DeepSeek-R1 专属扩展组件!无需魔法黑科技,只需一个可视化界面,3分钟完成大模型服务部署!

为什么是KubeSphere?三大核心优势

1. 化繁为简的标准化交付

通过集成 Ollama 运行时与 NextChat 交互界面,打造从模型推理到服务交付的完整闭环。开发者可在 KubeSphere 控制台轻松完成模型加载、服务启停与监控,如同管理普通微服务般简单。

2. 国产技术栈的深度适配

DeepSeek-R1 对中文场景的精准理解,与 KubeSphere 的国产化基因形成天然默契。实测在国产 CPU/GPU 服务器环境下,扩展组件兼容性表现优异,助力企业安全可控落地大模型。

3. 弹性资源调度与降本增效

基于 KubeSphere 的多租户管理与动态资源调度能力,企业可按需分配 GPU 资源,避免资源浪费。从 1.5B 到 671B 参数模型,一键适配不同算力场景。

KubeSphere 的 LuBan 架构

KubeSphere 的核心架构之一——LuBan,帮助我们实现了灵活、可扩展的 K8s 多租户管理。其特点包括:

- 模块化设计:KubeSphere 通过 LuBan 架构将其功能拆解为独立的微服务组件,提供灵活的扩展和定制能力。

- 高可扩展性:每个服务模块都可以根据需求进行独立扩展和替换。各个模块通过 API 或消息队列进行通信,支持按需启用或禁用特定功能。

- 高可用性与容错性:通过 K8s 的高可用特性,LuBan 支持服务容错,避免单点故障,保障系统稳定运行。

- 多租户支持:LuBan 通过不同模块支持多租户管理,确保各租户之间的隔离和安全性。

这三天我们做了什么?

- Day1:基于 LuBan 框架搭建扩展组件骨架

- Day2:完成 DeepSeek 模型与 Ollama 运行时的容器化适配

- Day3:集成 NextChat 交互界面并优化服务调用链路

整个过程如同拼装乐高积木——得益于 KubeSphere 的模块化设计,团队 80% 的精力聚焦业务逻辑,而非底层基础设施的反复调试。

技术选型

Ollama:AI 模型运行平台,支持在本地或集群环境中快速加载并运行大规模语言模型。

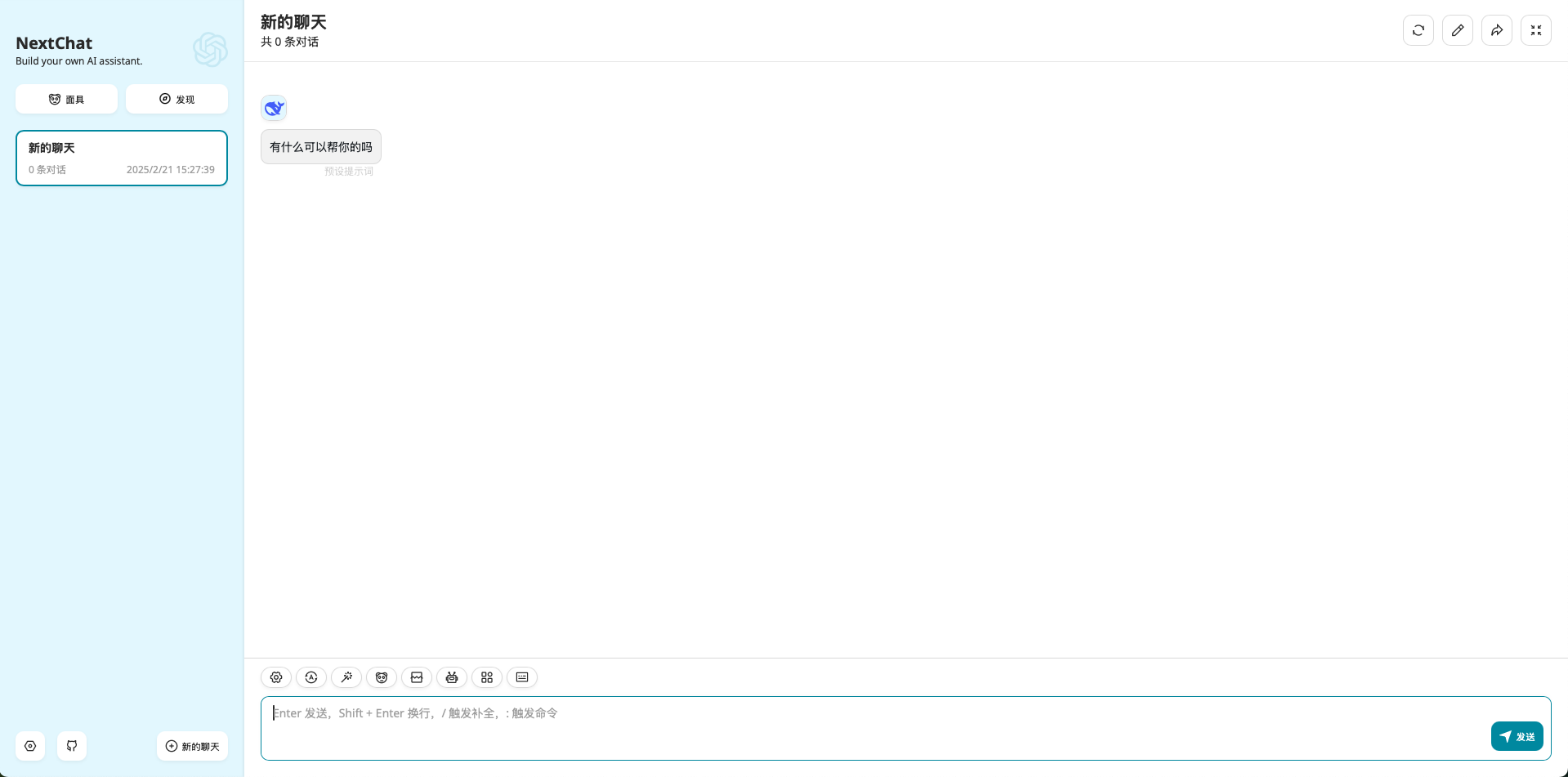

NextChat:提供了一个聊天机器人平台,结合自然语言处理(NLP)和机器学习(ML)技术,能够为用户提供流畅的对话体验。

实现原理

- 启动 Ollama 服务器:通过

ollama serve 启动 Ollama 服务器,提供 OpenAI 风格的 API 接口。

- 发起请求:使用

ollama client 发起 run model 请求。

- 模型加载:当 Ollama 服务器收到

run model 请求时,首先会检查本地路径(/root/.ollama/models)是否存在相应的模型。如果不存在,则从远程仓库拉取模型。

- 对话接口:通过

NextChat,用户可以与 Ollama 服务进行对话,利用 DeepSeek-R1 模型进行多轮对话、推理等任务。

安装和使用

- 安装 NVIDIA GPU Operator(可选)

- 安装 DeepSeek

代码已合入Kubesphere的扩展组件仓库

扩展组件开发步骤参考:扩展组件开发指南

并且完整安装步骤可参照官方文档:KubeSphere 快速安装

总结

通过这次基于 KubeSphere LuBan 架构开发 DeepSeek 专属扩展组件的实践,我们展示了 KubeSphere 在扩展性和灵活性方面的强大能力。我们为开发者提供了一个简单易用的工具,帮助他们快速部署和管理大模型服务。无论是在技术选型、架构设计,还是实际的服务交付过程中,这一实践都彰显了国产大模型和国产云原生技术的巨大潜力。

希望我们的实践能为更多开发者提供启发,让我们一同见证 AI 和云原生技术的未来!